IBM针对基于Apache Spark的新开发平台的数据科学家

使数据感可以涉及各种各样的工具,并且IBM希望使数据科学家“通过将它们放在一个地方来更容易地生活。

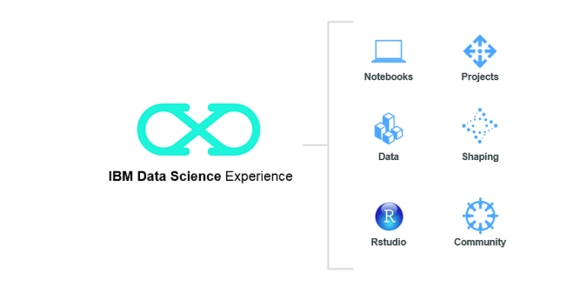

该公司周二发布了它所谓的数据科学经验,是云中的新开发环境,用于实时,高性能分析。

基于数据处理框架Apache Spark,数据科学经验旨在速度速度和简化嵌入数据和机器学习进入云应用程序的过程。新产品中包含的是Rstudio和Jupyter笔记本等工具。

开发人员可以点击Python,R和Scala。他们还可以在代码时查看样品笔记本和观看教程。附加工具专注于数据准备和清洁,可视化,规定分析,数据连接和调度作业。用户可以与他人合作并分享他们的代码。

数据科学经验现在可以在IBM Cloud Bluemix平台上获得。

“计算机科学与PC引入主流,”IBM Analytics高级副总裁Bob Picciano说。“通过数据科学,主要路障可以访问大数据集并具有与如此多的数据一起使用的能力。”

IBM已经投入了3亿美元的Apache Spark,包括为SparkR,Sparksql和Apache Sparkml提供贡献。

弗雷特的主要分析师Mike Gualtieri表示,数据科学经验结合了三个世界的最佳。

首先,“这是基于云的,所以所有的角度都可以轻松访问,”包括经验丰富的数据科学家,公民数据科学家和应用开发人员,Gualtieri说。

其次,该平台提供多种开源工具,包括Jupyter Data-Science笔记本,他补充说。

最后,“Apache Spark的力量位于这些工具后面,”Gualtieri表示,允许用户在云中的内存速度下使用机器学习工具分析数据。

公司越来越多地认识到商业软件中人工智能的潜力。

“向应用程序添加智能,无论您是呼叫IT,机器学习还是认知计算,现在是企业的最重要的,”Gualtieri说。